CCDA – Designing Data Center Networks (notes)

Les technologies et tendances qui influencent les data centers d’entreprises.

Les grandes entreprises ayant un nombre significatif de serveurs on besoins d’un data center dédié pour leurs employés, partenaires et clients dans le but de travailler, collaborer et interagir ensembles.

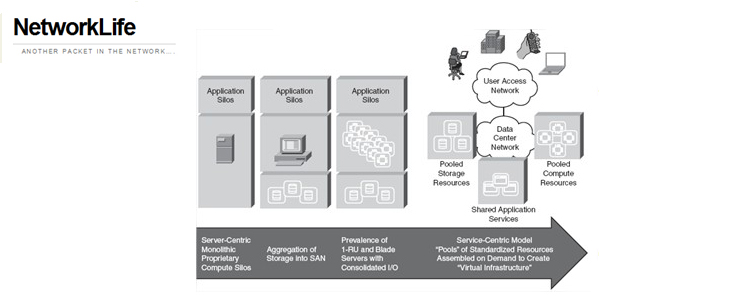

Historiquement, les data center ont évolués rapidement, en même temps que les besoins organisationnels. Les applications ont été implémentés au fur et à mesure en fonction des besoins, ce qui à causé ensuite une sous-utilisation de l’infrastructure mise en place.

Chaque silo à été mis en place en se basant sur des applications spécifiques, ce qui à nécessité un grand assortiment d’OS, de plateformes, de systèmes de stockages..Etc. très difficile à changer, étendre et très chère à gérer, intégrer, sécuriser et sauvegarder.

Le modèle “server-centric” des data center évolue vers un modèle “service-centric“.

Cette évolution inclus ceci:

- Déploiement de machines virtuelles (Vmware/Xen) qui cassent la relation : applications / hardware / OS.

Les machines virtuelles permettent d’avoir de multiples applications sur un seul serveur, indépendamment des autres, et de l’OS.

- L’élimination du stockage sur les serveurs, en le consolidant dans des pools de stockages. Le stockage réseau (SAN) permet :

- gestion simplifiée

- provisioning simplifié,

- amélioration de l’utilisation

- consistance des méthodes de récupération des données.

- La création de pools de serveurs qui peuvent êtres mis en communs, et provisionnés à la demande. Différentes appellations pour les serveurs:

- One-way – 1 processeur

- Two-way – 2 processeurs

- Four-way – 4 processeurs

- La consolidation de l’I/O des ressources, les I/O peuvent donc êtres mises en communs et provisionnées à la demande pour la connectivité aux autres serveurs, stockage et pools LAN.

Le Framework Cisco pour les Data Center d’entreprises

La consolidation et Virtualisation des ressources du data center nécessitent des fondations réseaux :

- Évolutives

- Redondées

- sécurisées.

Basé sur l’architecture SONA (Service-oriented Network Architecture), l’architecture Cisco pour les Data Centres d’entreprises fournis des best-practices pour adresser la demande de consolidation et de continuité pour le business des entreprises, tout en permettant de voir émerger les architectures SOA (Service-oriented architectures), la Virtualisation et l’informatique “à la demande” dans le data center.

Cisco Enterprise Data Center Architecture

- Networked Infrastructure layer – répond aux besoins de BW, latence, protocoles de connectivité user/server, server/server, server/storage dans une architecture modulaire et hiérarchique.

- Interactive services layer – Fournis les services d’infrastructure qui permettent d’assurer l’alignement de la vitesse et la sécurité des ressources avec les besoins des applications.

L’architecture Cisco Enterprise Data Center fournis une fondation évolutive qui permet d’héberger les différents systèmes et technologies suivantes:

■ N-tier applications: Les zones réseaux sécurisées supportent deux, trois, ou n-tier environnements d’applications avec des techniques qui optimisent la disponibilité des applications et l’utilisation des serveurs et du stockage.

■ Web applications: Accélération d’applications et technologies d’optimisation de server qui fournissent une évolutivité et l’accès aux applications web aux utilisateurs, peux importe où ils sont.

■ Blade servers: Serveurs qui ont des composants physiques réduits, requièrent moins d’espace, moins d’electrité. L’architecture Cisco fournis des fondations qui utilisent Ethernet et le switching Infiniband qui aident à optimiser la dispo, sécu et performance du Blade.

■ Clustering: les serveurs, solutions de switching, réseau haute-performance de Cisco basées sur Ethernet ou Infiniband permettent le déploiement d’applications qui utilisent intensément les I/O.

■ SOA and web service: L’architecture facilite la reliabilité, sécurité, déploiement d’une SOA.

■ Mainframe computing: Cisco fournis des technologies supportant le SNA (Systems Network Architecture), SNA-to-IP migration, connections fibre, et mainframes.

L’architecture est supportée par les technologies réseaux et les solutions qui permettent aux organisations de faire évoluer leurs infrastructures au travers des phases suivantes:

■ Consolidation: Intégration du réseau, des serveurs, des applications et du stockage dans une infrastructure évolutive et à la gestion améliorée en réduisant les couts et la complexité.

■ Virtualisation: Permettre au réseau de supporter la Virtualisation de l’informatique et du stockage en augmentant la facilité d’utilisation et l’adaptabilité tout en réduisant les couts.

■ Automation: La supervision dynamique, le provisioning automatique, l’orchestration de l’infrastructure du data center résultant en une améliorant de la gestion de la charge, des coupures, des attaques… L’agilité IT tout en minimisant les besoins opérationnels.

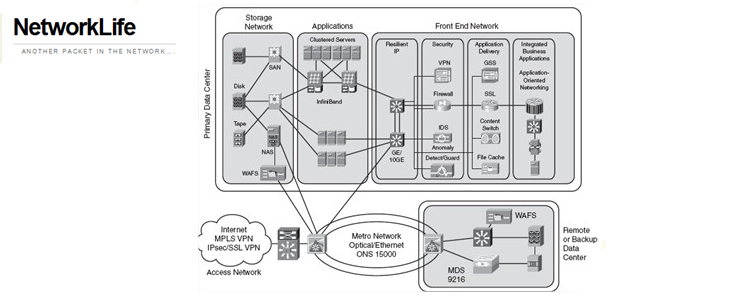

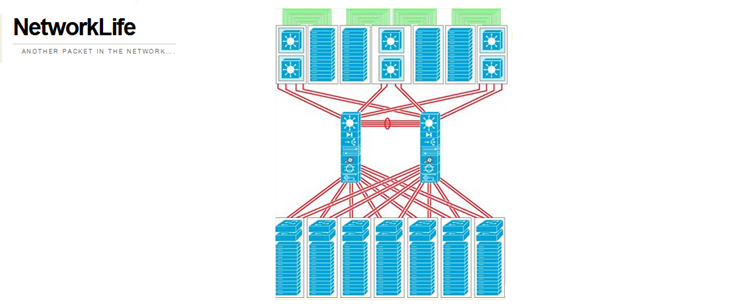

Ici un data-center “haute-performance” avec une topologie réseau qui nécessite plusieurs types de technologies et connectivités au travers de ses applications.

Infrastructure Data Center d’entreprise

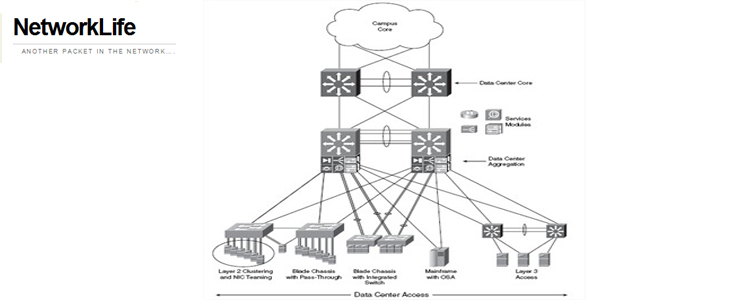

L’image ci-après est un implémentation de data center typique. Il suis l’architecture multilayer de Cisco. (Core, Aggregation, Access).

NOTE * In the Enterprise Data Center, the distribution layer is known as the aggregation layer.

L’infrastructure doit fournir une densité de ports et de la connectivité L2, L3 pour les serveurs en Accès, tout en supportant des services de sécurité (ACL, Firewalls, IDS) sur la couche d’Agrégation.

Les services réseaux sont déployés en paires redondantes pour éviter un SPOF (Single Point Of Failure).

Les 3 couches du DC en détail

Access Layer

Besoins de : L2, L3, Mainframe connectivité.

Le design varie en fonction des Switch d’accès utilisés (L2/L3), en général, ce sont des Switch hautes performances, avec peu de latence.

Les serveurs sont simplement ou doublement attachés.

Avec les doubles attachés, il faut un VLAN/Trunk entre les 2 liens pour supporter la même IP et le même masque de sous-réseau sur les 2 switchs sur lesquels le serveur est attaché.

Un mixe L2/L3 sur 1 RU (rack unit) et une plateforme modulaire fournis une solution très flexible, optimale pour les applications.

Aggregation layer

(Distribution) Agrégation des Uplinks de la couche d’accès vers la couche cœur. C’est un point critique pour le contrôle et les services d’applications.

Les équipements de sécurité et services d’application (Load-balancing, SSL, Firewalls, IDS) fournissent les services L4-L7 et sont déployés en modules dans la couche d’agrégation.

Ce design flexible à l’avantage de faire faire des économies d’échelles en réduisant le cout total de propriété (CTO) pour le client et en réduisant la complexité en baissant le nombre de composants à configurer et gérer.

Les services déployés sur la couche d’agrégation sont partagés avec tous les serveurs, alors que ceux déployés sur la couche d’accès bénéficient seulement aux serveurs directement connectés aux Switch d’accès.

Le Switching L2 est toléré sur la couche d’agrégation pour les conceptions existantes, les nouveaux designs n’ont de la L2 seulement en Accès.

Avec du L2 sur la couche d’agrégation du DC, les boucles devraient êtres gérées par STP. Dans ce cas, RPVST+ est recommandé pour assurer le contrôle des boucles logiques.

L’agrégation fournis donc de la connectivité L3 depuis le DC vers le Core et maintiens les connexions, et les sessions pour la redondance.

En fonction des besoins et du design, le biais entre L2 et L3 sur la couche d’agrégation peut être sur des switchs multilayers, firewalls..etc.

En fonction des implémentations, la couche d’agrégation peut avoir besoin de supporter une forte charge spanning-tree.

Core Layer

Voici les points importants à prendre en compte pendant le design de notre cœur de DC:

■ 10-Gigabit Ethernet density: Sans un cœur de DC, y aura-t-il assez de ports Ethernet sur le Switch du cœur, coté campus pour supporter chacun des campus, et la couche d’agrégation?

■ Administrative domains and policies: Un campus, et un cœur de DC séparés permettent d’isoler la couche de distribution des campus avec l’agrégation du DC pour le troubleshooting, la maintenance, l’administration, l’implémentation de règles (QoS et ACL).

■ Anticipation of future development: L’impacte qui peut résulter de l’implémentation d’un cœur de DC séparé à une date ultérieure à l’implémentation du réseau fait qu’il est bien mieux de l’installer au début..

Le DC connecte au cœur en utilisant des liens L3.

Les adresses sont des summary sur le cœur, et le cœur injecte des routes par défaut dans le DC.

Caractéristiques du core Layer:

■ A distributed forwarding architecture

■ Low-latency switching

■ 10-Gigabit Ethernet scalability

■ Scalable IP multicast support

Densité et évolutivité des serveurs

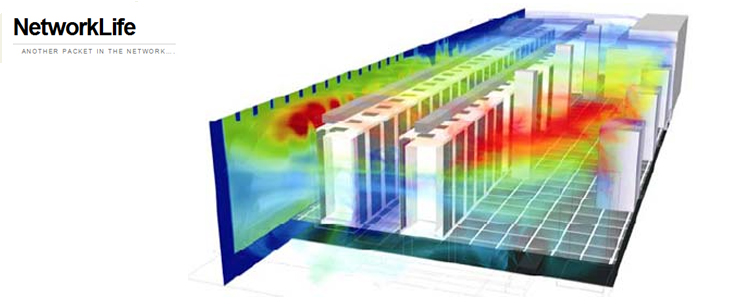

Certains incidents d’évolutivités dans le DC sont dues à l’environnement physique.

La couche d’accès la plus commune en entreprise aujourd’hui est basée sur des Switchs Catalyst modulaires tels que les 4500 et 6500. Cette topologie est évolutive et fiable.

Les DC sont en constante augmentation du nombre de serveurs.

En même temps, la densité à été améliorée avec les 1RU et des solutions blade.

3 challenges ressortent ici:

■ Cable bulk: En général, 3 à 4 interfaces sont connectées à un serveur. Avec une forte densité de serveurs par racks, la gestion du cablage peut devenir très difficile !

Solution : Top-of-rack Architecture / FCoE (Article bientôt..)

■ Power: La densité qui augmente des composants dans un rack nous conduit à plus de besoins ne électricité par rack. La prévision du besoin en alimentation est primordiale.

■ Cooling: Le nombre de cables présents dans les goutières et les racks bloquent les flux d’airs requis pour refroidire les équipements. De la même manière, les serveurs nécessitent plus de capacité de refroidissement à cause de la densité de serveurs par rack.

Ces challenges ont forcés les clients à trouver des solutions alternatives pour espacer les baies, en modifiant les routes de câbles, en d’autre termes, ne pas déployer de solutions à haute densité.

Pour résoudre d’autre problèmes, ils utilisent des solution de Swithing basées par baies. Les 1 RU Top-of-rack Switch permettent de réduire le nombre d’incidents de câbles et d’améliorer l’aération des serveurs.

L’autre solution est de placer le Catalyst 6500 près des rangées de racks afin d’avoir moins de Switch à gérer, et des câbles moins longs.

Partie sup: Catalyst collés aux baies

Partie inf.: Top-of-rack..